Cet article est également disponible en:

Anglais

En 2020, l’équipe de Dada ! Animation officialisait son lancement au Festival d’Annecy (l’entité se nommait encore Hue Dada ! à l’époque).

Trois ans plus tard, nous avons profité du même évènement pour retrouver Quentin Auger, cofondateur et directeur de l’innovation du studio, pour évoquer les derniers projets de l’équipe.

Plus précisément, nous l’avons interviewé sur les usages de l’IA et de la 3D temps réel au sein de Dada ! Animation. Au menu : transfert de style, Unreal, capture volumétrique, immersion, mais aussi un échange plus libre sur les enjeux des IA génératives !

3DVF : Bonjour Quentin ! Nous avions déjà interviewé Dada ! Animation en 2020 : à l’époque, l’entité venait de se créer, et s’appelait Hue Dada ! Productions. Pourquoi ce changement de nom, d’ailleurs ?

Quentin Auger : Le nom d’origine était un héritage, nous avions rejoint une structure qui existait déjà. Et l’an passé, juste avant le Festival d’Annecy, nous avons fait un bilan, une sorte d’audit de notre image : nous avons alors changé de nom, d’identité graphique.

Le changement de nom avait pour but de gommer un côté trop enfantin, et un nom trop français qui n’était pas compris par les étrangers (ils ne savaient pas le prononcer et le sens n’était pas clair), mais aussi de resserrer notre identité sur « Dada », en forme d’hommage au mouvement artistique éponyme et aux valeurs de perpétuel mouvement créatif qu’il porte.

3DVF : Nous faisons cette interview juste après une conférence « Temps réel & IA : ces outils vont-ils révolutionner l’animation ? » au Festival d’Annecy. Tu faisais justement partie du panel.

Tu as notamment évoqué Ils étaient des millions / They were millions of them, un projet de documentaire pour Seppia / Indi Film / Arte.

Dada ! Animation a notamment utilisé EbSynth, que nous avions évoqué sur 3DVF lors de son lancement. Un outil assez surprenant à l’époque, en 2020 !

C’est vrai que c’est un curieux logiciel, un peu unique dans son genre. A l’époque, il avait attiré les regards, puis un peu disparu de l’actualité. On l’a ressorti des cartons car il collait à notre problématique : faire du transfert de style, ce qui est souvent fait par rotoscopie (on filme une séquence, on redessine par-dessus dans un autre style).

On s’est demandé si EbSynth pouvait aider. C’est ce genre de recherche et d’adaptation technologique à des problématiques d’animation diverses que notre « Digital Lab » aime traiter. Celui-ci est central aux développements des nouveaux projets que Dada aborde, d’autant plus qu’on milite pour un « décloisonnement » de l’animation, c’est-à-dire pour son application à des cas d’usages nouveaux (documentaire, XR, etc.)

Et ce qui est amusant, c’est que depuis, avec l’irruption des IA Génératives comme Stable Diffusion par exemple, et tout l’écosystème autour (ControlNet et autres), il y a beaucoup de gens qui font du transfert de style. Et certains utilisent l’IA de “warping” qu’est EbSynth (elle n’est pas générative), car il a tendance à stabiliser les résultats, c’est son avantage mais aussi son défaut : il a tendance à laisser traîner des éléments qui devraient disparaître, il tord les images plutôt qu’il ne les transforme.

3DVF : Rappelons brièvement son fonctionnement, d’ailleurs : EbSynth prend en entrée une séquence vidéo, des keyframes sur lesquelles on aura appliqué le style voulu, et EbSynth va appliquer, propager ce style sur toute la séquence.

Exactement, EbSynth tente de stabiliser le style des keyframes sur les images de la vidéo. Le résultat est très différent de beaucoup d’IA génératives qui génèrent la plupart du temps des vidéos cauchemardesques, fiévreuses, qui manquent de cohérence d’une image à l’autre.

De notre côté on n’a pas utilisé Stable Diffusion qui hallucine une image pour chaque frame, on a utilisé la patte d’un vrai artiste pour les keyframes, et la vidéo d’entrée est de l’animation 3D générée via Unreal Engine.

A noter, on s’est rendu compte que pour qu’EbSynth fonctionne bien, il vaut mieux des zones très définies, en désactivant les effets, l’atmosphère. Il est même préférable d’éviter les ombres, cela permet de laisser l’artiste les dessiner comme il les souhaite sur les keyframes. Et pas besoin d’avoir des couleurs réalistes, il faut vraiment surtout que les zones soient bien définies. Et donc, au fond, ne pas utiliser toute la puissance du moteur.

Autrement dit, on fait du Unreal moche [rires], mais exprès, pour la suite du workflow !

Le projet en est à l’étape du pilote. Une grosse partie des fonds a été levée, notamment du côté des aides financières françaises.

3DVF : Revenons aussi sur VRtist, un projet de recherche que nous avions découvert durant Laval Virtual il y a un an et demi sur le stand de l’IRISA/INRIA. Dada ! Animation a participé.

Pour résumer, VRtist est un outil d’animation keyframe en VR, créé par des scientifiques pour étudier les problématiques d’expérience utilisateur dans ce contexte.

VRtist fait partie d’un projet plus large (le projet “Invictus” dont nous avons créé le trailer) , qui implique à la fois des laboratoires et partenaires industriels, avec par exemple une université allemande, une entreprise irlandaise, avec notamment de la vidéo volumétrique : une limitation de cette technique, qui est un peu de la photogrammétrie en vidéo, est qu’on peut difficilement la retoucher après coup.

3DVF : Oui, on a par exemple eu l’occasion d’interviewer 4DViews, spécialiste du sujet, qui propose à la fois de la prestation, d’équiper des studios, des outils logiciels. Leur outil 4Dfx permet des retouches, mais assez limitées : par exemple, des déformations, un changement de regard, une transition entre deux séquences, mais pas de l’animation poussée.

Un des enjeux du projet était justement d’éditer la vidéo volumétrique après coup, donc rigger ces éléments, les modifier. Par exemple en immersion, en VR.

Nous sommes arrivés assez tardivement. Ubisoft Motion Pictures était partenaire industriel pour VRtist, ils apportaient leur savoir-faire et des cas d’usage concrets. Mais la structure s’est éteinte durant le projet, et le consortium de chercheurs a tenté de trouver d’autres structures expertes en animation qui seraient intéressées pour prendre la relève. Ils nous ont contactés, d’autant que nous étions déjà en lien avec l’IRISA de Rennes sur d’autres travaux, et nous avons rejoint le projet en tant que prestataires (une fois le projet lancé, il était trop tard pour modifier la composition du consortium, d’où ce rôle de prestataire).

Par contre, ils n’allaient tester que l’animation de bipèdes, d’humains. Cela convenait parfaitement aux besoins d’Ubisoft. Mais nous avons une approche non réaliste, avec des petits monstres, des personnages très divers, du cartoon… On avait donc plein d’autres problématiques, qui touchent en particulier au rigging. Or cette question n’avait pas du tout été intégrée dans VRtist. Comment désigner une chaîne de joints qui n’est pas un bras ou une jambe, par exemple, pour gérer un tentacule ?

On a donc listé nos propres problématiques, des plus simples au plus complexes (faire bouger un objet dans l’espace, le déformer, créer une/des chaînes de joints, rigger des choses variées…).

Evidemment, ils ne pouvaient pas changer leur roadmap sur VRtist alors qu’on était sur la dernière année du projet et qu’ils devaient commencer à tester, rendre des comptes, donc on a opté pour rigger dans Maya, puis on a utilisé un outil qui transférait le rig Maya (avec une approche haut niveau, qui comporte des contrôleurs, les curseurs pour animer, associés aux joints et blendshapes) vers Unity. Les contrôleurs apparaissaient donc et étaient aussi valides dans Unity, et les équipes de l’IRISA travaillant sur VRtist pouvaient alors éditer les mouvements de ces contrôleurs en plus de ceux des joints.

Cela a permis de retomber sur le sujet prévu de leur côté, avec nous qui prenions en charge le rig, et nous avons fourni notre cas d’usage, créer une animation sur plusieurs de nos personnages.

3DVF : Et le bilan du côté de Dada ! Animation ?

Ce sont… Des outils de chercheurs qui découvraient l’animation ! [rires]

J’ai trouvé ça passionnant, avec beaucoup de bienveillance des deux côtés, beaucoup de curiosité intellectuelle. On a tellement apprécié que l’on va continuer à travailler ensemble.

De notre côté, on leur a appris les concepts de base de l’animation, l’application des 12 principes de l’animation, etc. On leur a fait rencontrer notre cheffe animatrice qui leur a donné quelques cours, a testé les outils. Et en parallèle, les mêmes outils ont été testés sur des élèves de l’école Creative Seeds, basée à Rennes. Cela a permis de tester les outils sur des animateurs de niveaux très variés, de débutant à professionnels.

Ce qu’il en ressort, c’est que ces outils sont très pratiques et très adaptés à des personnes qui débutent en animation, veulent faire des choses simples. Pour des professionnels qui ont besoin d’un contrôle très fin, il y a des choses passionnantes, fascinantes : pouvoir déplacer les éléments à la main dans l’espace, c’est génial. Mais hélas, l’animation ne se cantonne pas à ça, tout ne se résume pas à des trajectoires, comme animer une expression faciale, une contrainte, ce sont aussi des questions de timing, par exemple.

Il y a encore du travail, donc, mais c’est prometteur et très fun.

L’étude est terminée chez eux et a été rapportée il y a quelques mois, l’équipe a même eu les félicitations du jury sur l’ensemble du projet (qui est loin de se limiter à VRtist). La commission a apparemment été impressionnée par l’entente et la collaboration au sein du consortium.

Tout ça nous a inspirés à continuer à travailler avec l’IRISA, sur des outils utilisant l’IA pour l’aide à l’animation keyframe. Avec de la VR ou non, et d’autres éléments qui entreront en jeu : son, gestes.

Comme pour VRtist, le résultat sera un prototype, et le projet sera open source. On est en train d’ailleurs nous aussi, de notre côté, de préparer des projets open source dans le domaine du pipeline cette fois.

3DVF : Durant la conférence, tu as aussi très brièvement évoqué un autre projet de Dada ! Animation, “L’entre deux mondes du Vaudou”. Un futur documentaire qui mêle LIDAR, effets visuels, vidéos 360, temps réel : peux-tu nous en dire plus ?

C’est un projet de notre Digital Lab à nouveau pour Seppia, que j’évoquais plus haut en parlant d’EbSynth. Une société documentaire que l’on aime bien (et c’est réciproque) et qui touche vraiment à tout.

Et Seppia travaille sur un documentaire autour de la religion vaudou. Pour lever des fonds pour le pilote, ils avaient besoin d’un proof of concept pour montrer que ce qu’ils ont en tête est réalisable. Ce sera un documentaire immersif, en vidéo 360°. Une partie étant filmée sur site, au Bénin, à Haïti.

Ils sont donc allés au Bénin, filmer en 360° des prêtres vaudou et des gens dans la rue. Ils ont aussi utilisé notre iPhone Pro et son LIDAR pour faire de la capture volumétrique en même temps que la capture à 360°. Pour la même session vidéo, on a donc à la fois de la vidéo immersive et de la capture LIDAR.

Comme le vaudou mêle le monde du quotidien que l’on connaît et un monde parallèle, celui des esprits, Seppia voulait pouvoir représenter ce second monde, le faire émerger en se servant du LIDAR pour ajouter des effets volumétriques.

Ils voulaient donc savoir si Unity pourrait permettre de créer et intégrer ces effets dans la vidéo 360°, générer à nouveau derrière une vidéo 360°, valider que le compositing fonctionnerait visuellement.

On a donc géré la partie technique, et ça fonctionne, c’est assez joli ! Un projet très fun de notre côté. Seppia est du coup en pleine levée de fonds pour lancer le pilote.

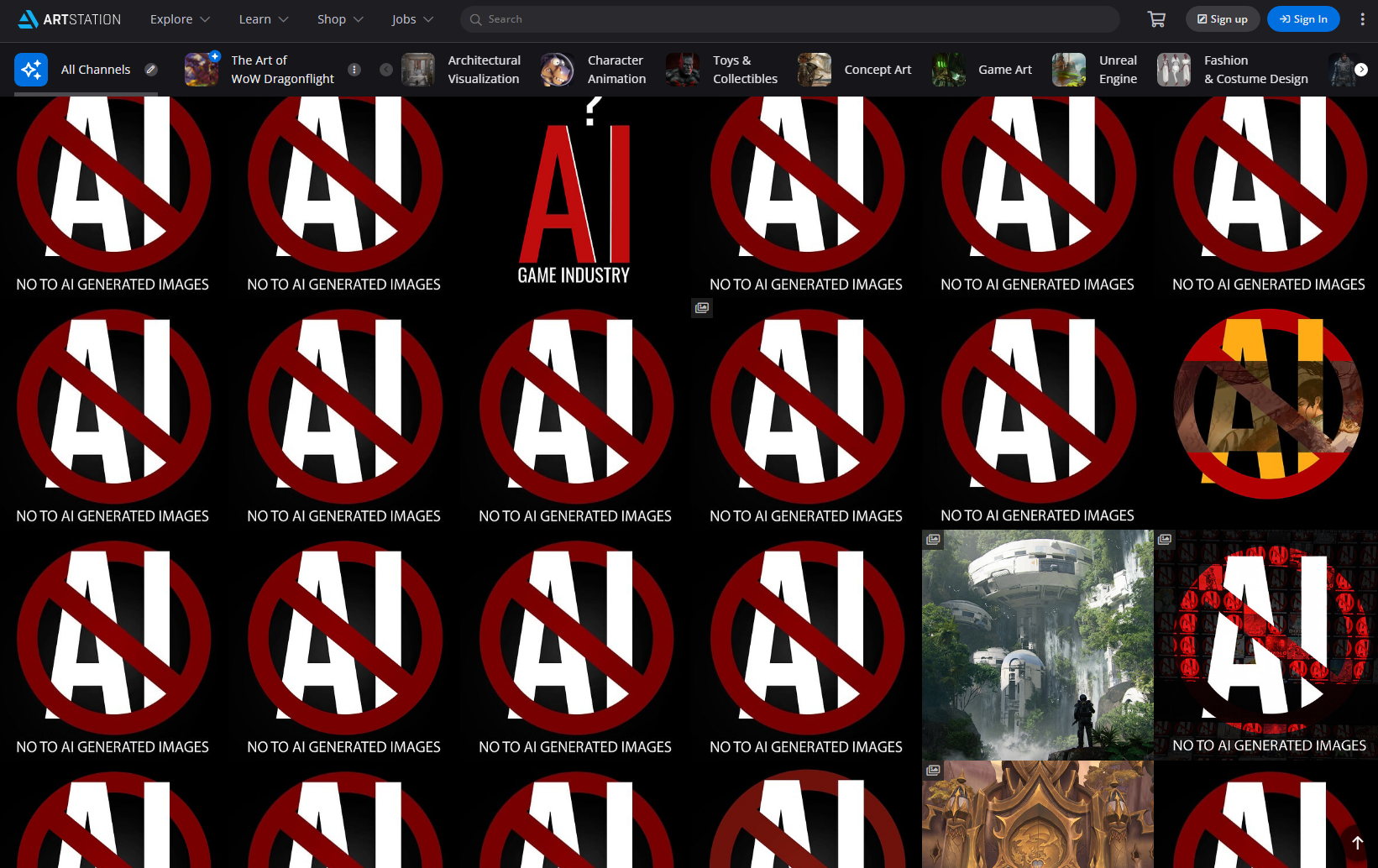

3DVF : Tu as aussi parlé dans la conférence au Festival d’Annecy de l’aspect éthique des IA, et tu évoquais son impact sur la qualité même des outils. D’un côté, des solutions qui ont amassé des quantités colossales de données sans demander aux artistes, et qui proposent du coup des résultats impressionnants. Et en parallèle des outils qui se veulent plus éthiques, chez NVIDIA et Adobe, mais qui du coup ont moins de données.

Sans compter qu’ils ne sont pas forcément entrés aussi tôt dans ce domaine.

C’est un sujet complexe, d’autant que chaque jour sortent de nouvelles informations qui modifient les données. Pour Adobe par exemple, ils mettent en avant l’aspect éthique, sans doute en partie pour éviter les procès. Chez Epic, les artistes ont interdiction d’utiliser de l’IA, et ils doivent même prouver qu’ils ne s’en servent pas : les artistes qui travaillent à l’autre bout du monde doivent montrer qu’ils ont fait des concepts, par exemple. Le but étant là encore d’éviter des problèmes légaux.

Et en fait, Adobe dit qu’il est possible de créer de l’IA sans avoir cette crainte de procès, car leur IA sous Photoshop a été entraînée sur des images Adobe Stock, donc des images sur lesquelles les artistes ont a priori donné à Adobe les droits nécessaires.

Le hic, c’est que les contributeurs d’Adobe Stock ont certes sans doute utilisé leurs propres oeuvres… Mais certaines de celles-ci ont potentiellement été créées avec des IA. Le problème du copyright revient donc, en cheval de troie !

3DVF : Un autre souci potentiel étant qu’il y a des précédents de personnes tentant de mettre en ligne sur les banques d’images, avec succès, des images créées sans IA mais sur lesquelles ces personnes n’ont aucun droit. Un peu comme on a vu récemment une base de données de modèles Sketchfab sous licence Creative Commons, sauf que certains de ces modèles n’ont rien à faire avec ce genre de licence (par exemple, des modèles de Mario rippés depuis des jeux Nintendo).

Voilà, il peut y avoir du vol d’oeuvre, mais je pense qu’Adobe Stock a des outils pour éviter ce genre de problème. En revanche, des images créées à l’aide d’IA, c’est plus complexe à détecter.

Et c’est un sujet difficile car on ne peut techniquement pas déposer un style. On ne peut pas avoir de droit d’auteur, et donc de copyright sur un style visuel. On ne peut déposer que des oeuvres concrètes. Le problème des IA étant que l’on peut générer des images copiant le style d’un artiste.

A noter, pour son IA générative, Adobe empêche de citer des noms d’artistes dans un prompt, justement pour éviter ce genre de génération.

Mais il y a peu, un artiste a réussi à utiliser l’IA d’Adobe, dans Firefly (la même est disponible dans Photoshop en version beta), des images très, très, très proches de son style. Il a commencé à en parler sur les réseaux sociaux.

Le problème de fond étant donc de faire une bonne curation dans Adobe Stock pour entraîner l’IA sans inclure des images déjà générées par IA.

3DVF : Oui, là encore on retombe sur le cas de la base de modèles Sketchfab rippés : comme il n’y a pas eu de filtre humain, on se retrouve avec de nombreux modèles présentés comme libres de droits qui ne le sont pas.

Une solution possible étant de laisser aux studios le soin de générer leurs propres données pour entraîner les IA : c’est notamment l’approche retenue par Golaem dans un projet qu’ils présentaient aux RADI-RAF en fin d’année dernière.

Oui, et c’est ce que disait Blue Spirit durant la conférence. C’est la démarche qu’ils ont mise en place en interne, après avoir échangé sur le sujet avec leurs avocats. Même chose pour Epic.

Et on a la même philosophie : si on a un doute, c’est que ça sent mauvais !

Et il y a aussi l’usage éthique, s’interdire de taper des prompts « dans le style de x ».

C’est compliqué car c’est l’inverse de ce qu’on fait traditionnellement dans notre métier. Dans un moodboard, on va inclure du Klimt et du Spielberg, etc.

Egalement présents : Olivier Lelardoux (Blue Spirit), Tom Box ( Blue Zoo), Chad Nelson (Critterz), Paul Robinson (Genius Brands International), Yann Marchet (modération)

3DVF : On pense aussi aux musiques temporaires, qui peuvent influencer fortement le résultat final.

Je vais même aller plus loin, on est une industrie de “faussaires par obligation”. Quand un directeur artistique arrive sur un projet et pose sa patte, quelques fois inspirée d’autres, il est entouré d’une équipe d’artistes du studio qui vont respecter son style, et à qui on demande donc littéralement de le copier, puisque ce n’est pas lui qui fait l’ensemble du projet.

Quelque part ça ressemble aux ateliers de peinture, avec un maître comme Rembrandt qui était entouré d’autres artistes, « faussaires officiels », qui avaient le droit de reproduire son style.

D’ailleurs ça pose la question de savoir pourquoi en animation on ne voit pas le souci à ce que des artistes s’approprient une direction artistique sur un projet du studio, et donc copient ce style, mais en IA ce serait interdit. Bref, sujet touchy et complexe, et avec beaucoup de flous juridiques pour le moment.

3DVF : On peut noter que l’on a ces débats dans le milieu artistique, alors que depuis de nombreuses années tout le monde utilise Google Traduction, entraîné sur des textes traduits, sans avoir demandé leur avis aux traducteurs et traductrices…

Même chose pour le code, je pense ici à des outils comme GitHub Copilot qui aide à coder. On peut l’entraîner sur son propre code, mais aussi sur le code disponible sur GitHub : or on n’a pas assisté à de telles levées de bouclier de la part des développeurs, pas de demandes à ma connaissance pour pouvoir être exclu de ces données d’entraînement. (ce qui est a priori très compliqué après coup !)

On a surtout vu ça dans l’image, pour les voix des comédiens et comédiennes de doublage, et à peine dans la musique.

3DVF : Sans doute en raison d’un mélange de droit (tout ne peut pas être déposé, breveté), ou de culture selon le milieu. Et la crainte dans certains métiers de voir les IA détruire des emplois. On a d’ailleurs vu des studios qui utilisent explicitement l’IA dans ce but et ne le cachent pas.

Oui, ça a commencé. Des designers « libérés » par leurs entreprises en raison de l’IA. On a connu le même mouvement avec l’arrivée du numérique. Chaque technologie qui automatise oblitère des métiers et destructure des organisations, souvent des tâches pas si créatives que ça, ou de basse qualité.

Et c’est le paradoxe ici, on est dans le secteur créatif, on embauche les artistes pour leur savoir-faire, et en même temps il y a de l’image produite au kilomètre, des projets où l’aspect artistique, créatif est finalement très secondaire.

Et avec la pression sur les prix, ces rôles (pas les cœurs de métiers eux-mêmes) risquent d’être remplacés.

Paradoxalement, ça rend d’autant plus précieux le savoir-faire des artistes qui travaillent sur du qualitatif, ont du savoir-faire.

Je repense aussi ici à l’arrivée de la photo, qui a tué le métier des portraitistes en peinture, qui faisaient du travail dans un but non esthétique, et ça a disparu. En revanche il y a toujours des peintres, qui se focalisent sur l’artistique. Et on note qu’ils ont souvent intégré la photo dans leur process.

Même chose pour la synthèse en musique, qui a supprimé des instrumentistes : des violonistes qui enchaînaient les petits projets ont disparu. Mais en parallèle, les orchestres sont d’autant plus précieux, pour un autre niveau de qualité.

A chaque fois, l’automatisation bouleverse les métiers (et en crée beaucoup de nouveaux !)

3DVF : Va-t-on du coup vers une contraction de l’industrie ? Parallèlement à une explosion de la génération visuelle, comme les appareils numériques et smartphones ont décuplé le nombre de photos produites, mais ont aussi fait chuter le nombre de photographes ?

C’est vrai que désormais n’importe qui peut filmer avec son téléphone, et les réalisateurs en sont d’autant plus précieux. On peut aussi se souvenir que l’arrivée de la 3D a d’abord entraîné la fermeture de studios 2D aux USA, tout en restant présente en Europe, au Japon. Mais on a fini par assister à un retour en arrière, même chez Disney !

3DVF : On a d’ailleurs vu à Annecy un court fait pour leur centenaire, avec un mélange de prises de vues réelles et… De 2D !

Et on voit que des Arcane, des Spider-Verse s’inspirent de la 2D. Paradoxalement, après avoir créé un effondrement de la 2D, les nouvelles techniques provoquent sa résurgence, et soulignent son intérêt.

3DVF : Du coup, pour toi, on se dirigerait vers une industrie dans laquelle les studios qualitatifs n’auraient pas forcément grand chose à craindre, mais dans laquelle les studios produisant davantage en low cost, à la chaîne, seraient voués à la contraction et à une crise ?

Sans blocage légal, oui. Car il ne faut pas se leurrer, sans législation, le blocage éthique ne va pas tenir longtemps.

Je précise tout de même que j’ai peut-être un biais sur les sujets d’IA, ayant été formée dans une université d’ingénieurs. On avait des cours de philosophie des techniques, un de nos enseignants était Bernard Stiegler, philosophe qui fut aussi directeur général adjoint de l’INA, chef du département innovation. Il notait la différence entre travail et emploi. Il disait que l’emploi, c’est employer des gens à aider des machines, le terme d’emploi ayant d’ailleurs été inventé durant la révolution industrielle. Le travail, pour lui, est une tâche dans laquelle les gens s’améliorent et développent des compétences.

La toxicité du travail, les bullshit jobs venant donc du fait qu’il s’agit en fait surtout d’emplois, pas de travail.

Et je dis ça car les gens adorent voir le travail des gens. Quand je vais voir Spider-Verse au cinéma je vais voir le travail des gens, alors que quand je suis devant une pub, le métier de publiciste, honnêtement je m’en fiche un peu. Je vois que des gens ont été employés pour produire une pub.

3DVF : Ce type de réflexion crée des réactions paradoxales chez les jeunes artistes que l’on a pu croiser dans les écoles, entre la crainte de ne pas avoir d’emploi, et à l’inverse une volonté chez certains d’explorer ces nouveaux outils, en poussant les enseignants sur ces sujets.

Je vois la même chose, que ce soit en recrutant ou dans les conférences que je donne en école. Beaucoup dépriment, ont passé 5 ans à apprendre des compétences, dépensé beaucoup d’argent, et voient qu’une IA donne le même pouvoir à n’importe qui en quelques secondes.

Du moins, donne l’impression de donner ce pouvoir : en pratique ce n’est pas le cas, ce n’est “que” du prompt engineering, la capacité à trouver les bons prompts (un nouveau travail ?). Le coeur de leur métier, c’est-à-dire apprendre à faire et défendre les choix qu’on fait pour chaque pixel de chaque frame, lui, est bien ce qu’ont appris ces étudiants, et il reste très précieux, quelque soit la technologie avec laquelle ils le pratiqueront !

3DVF : Certaines personnes utilisant de l’IA s’autodésignent sous le terme AI Artist… Qu’en penses-tu ?

Mais en fait, on ne s’autodésigne pas artiste, cela vient du regard des autres. Une personne « employée », pour reprendre la réflexion faite plus haut, à sortir des images créées par IA, n’est pas un artiste. Le côté artiste est dans l’œil de la personne qui regarde. En tous cas je vois ça comme ça.

Plus largement, en discutant de ce sujet avec des amis artistes ayant une longue expérience, il en ressort qu’ils ont l’impression de revivre ce qui s’est passé il y a une trentaine d’années avec l’arrivée de l’image de synthèse (à l’époque on utilisait plutôt ce terme que 3D). Plein d’algorithmes entre lesquels choisir, beaucoup d’outils, des choses qui ne marchaient pas très bien, à tel point que les animateurs ne se sentaient pas trop en danger jusqu’à la sortie de Toy Story qui a changé la donne.

Mais on sentait qu’on inventait de nouveaux métiers, moi-même je suis devenu animateur, un métier dont je connaissais le nom, mais je suis ensuite devenu setuper, pipeline developper, TD… Autant de nouveaux métiers qui ont été inventés au fil des besoins !

Et l’IA me rappelle effectivement vraiment cette époque.

3DVF : Quentin Auger, merci beaucoup pour tes réponses et ton point de vue ! Ces sujets provoquent des débats houleux et génèrent des discussions passionnées, il est donc toujours intéressant d’avoir de nouveaux éclairages. Nous continuerons évidemment à suivre ce domaine de près sur 3DVF, de même que ses conséquences. Et nous aurons bien entendu aussi l’occasion d’évoquer Dada ! Animation !

Pour en savoir plus

- Dada ! Animation ;

- Notre article sur l’écosystème créatif rennais, dont font partie l’IRISA, Creative Seeds cités dans l’interview ;

- Invictus ;

- Suivez 3DVF : Youtube, Instagram, Facebook, Twitter, LinkedIn.