|

La société Progiss (qui, pour rappel, est le partenaire de 3DVF) a récemment mis en place un système de stockage centralisé pour un de ses clients. |

Nous vous proposons dans cet article de nous pencher sur ce projet, afin de vous donner une idée des avantages de ce type d’installation et des possibilités offertes. |

|

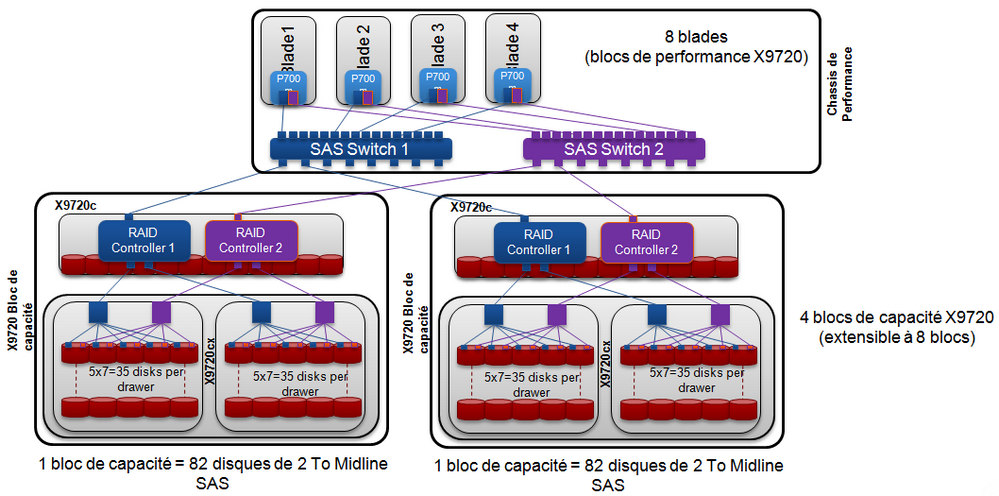

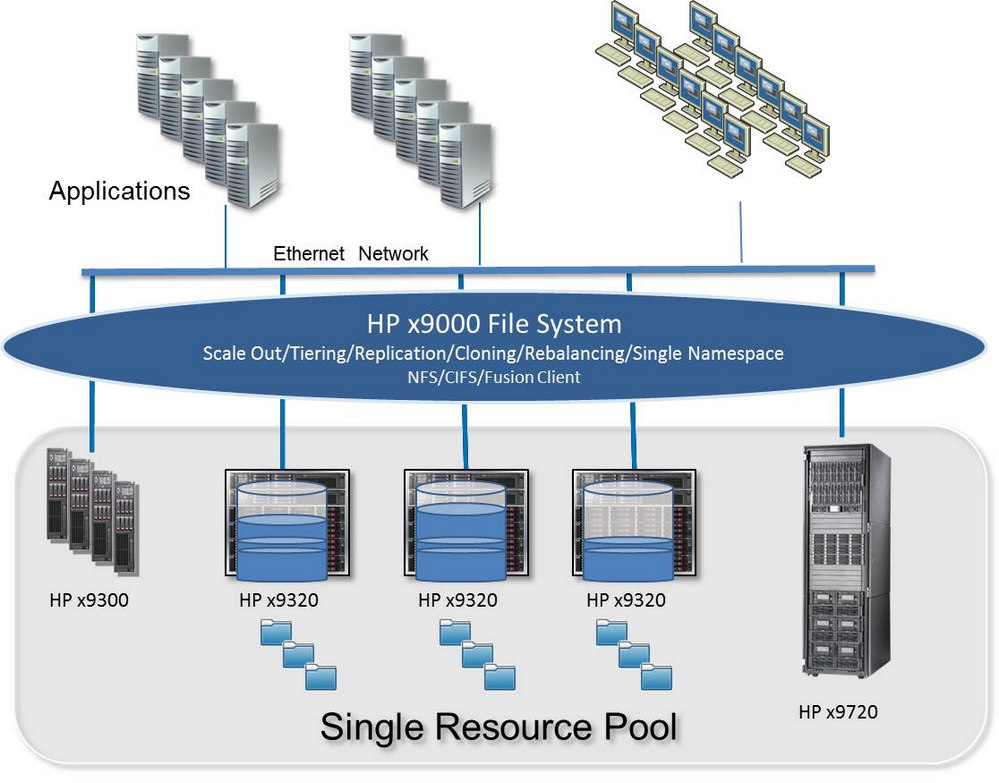

Concrètement, la solution retenue est un ensemble reposant sur le système de stockage réseau HP X9320. Deux serveurs sont associés à un système de stockage comportant un nombre important de disques durs, par rangées de 4 blocs de 3 disques. De quoi, en utilisant 4 rangées et des disques 450 Gb SAS 15000tr/min comme dans l’installation présentée ici (sachant que l’on peut aujourd’hui disposer de disques 600Go SAS ou 2 Tera octets SATA), disposer d’une capacité cumulée théorique assez impressionnante. Le système est en Single Namespace : pour les utilisateurs ayant leurs données sur le système, ils ne voient qu’un gigantesque espace de stockage, et pas des dizaines de disques. Un fonctionnement en boîte noire, donc, ne nécessitant pas de connaissance technique pointue. Bien entendu, la capacité réelle est en fait inférieure à la capacité obtenue en cumulant les disques installés, le système étant destiné à éviter les pannes… Redondance et gestion des pannes En effet, avoir une capacité de stockage conséquente ne sert à rien si le système est faillible, et que le moindre crash d’un disque fait perdre des données. |

Pour pallier à cela, les disques sont en RAID 5 : en clair, un groupe de disques RAID 5 peut supporter la perte d’un disque dur quelconque, grâce à une certaine redondance. Mais il faut évidemment remplacer immédiatement le disque en question, pour éviter tout problème en cas de second crash. En l’occurence, il est possible d’avoir un disque en spare dans le groupe, autrement dit un disque dur en attente, qui prend le relais dès qu’une panne survient, sans intervention particulière. Le gestionnaire du système pourra, de son côté, avoir une bonne idée de la santé de son infrastructure et des problèmes éventuels, soit via l’interface de gestion intégrée, soit par des alertes e-mail. En plus de la redondance liée aux groupes de disques, il y a également une redondance entre rangées. Au final, 50% de l’espace de stockage environ est « perdu » du point de vue de la capacité de stockage pure, mais la contrepartie est un système quasi infaillible, ainsi que des performances décuplées : qui dit redondance entre disques, dit aussi possibilité d’obtenir des débits confortables ! |

Ci-dessus, Schéma du système ; ci-dessous, l’ensemble global, avec de haut en bas : les stations, le switch et le système de stockage.

Détail de la façade du système de stockage : serveurs, groupes de disques durs.

Les LED permettent de vérifier le fonctionnement de l’ensemble : les deux disques dont les LED sont éteintes

sont les disques de spare. Inactifs, ils sont présents pour prendre le relais en cas de panne.

|

En pratique ? Les débits, parlons-en : pour tester le système, l’équipe Progiss l’a mis à l’épreuve en utilisant simultanément : Le tout, bien évidemment, en lecture/écriture sur le système. Le système est 30 à 50 Workstation et 50 Renderfarms. |

Et demain ? Du côté de l’évolutivité, les choses sont simples : le système permet de rajouter des blocs supplémentaires en fonction des besoins , chaque bloc est composé de 2 serveurs et de baies de HDD (soit avec disque durs SAS pour une performance accrue soit en SATA 2 To pour une volumétrie plus importante ) , l’espace de stockage se trouvant augmenté de façon transparente pour l’utilisateur (tout se passe comme si, pour l’utilisateur du studio, la capacité de l’ensemble de stockage avait juste augmenté : pas de nouveau disque dur visible). Pas d’installation complexe, il suffit de brancher les disques. L’avantage de rajouter un bloc (serveurs et hdd) est de rajouter de la performance « réseau » (4 ports 10 Gb + CPU + RAM) et du débit disque. Il est important de comprendre qu’on ne peut obtenir de la performance et tenir une charge de travail en simultané qu’en cumulant ces deux caractéristiques. |

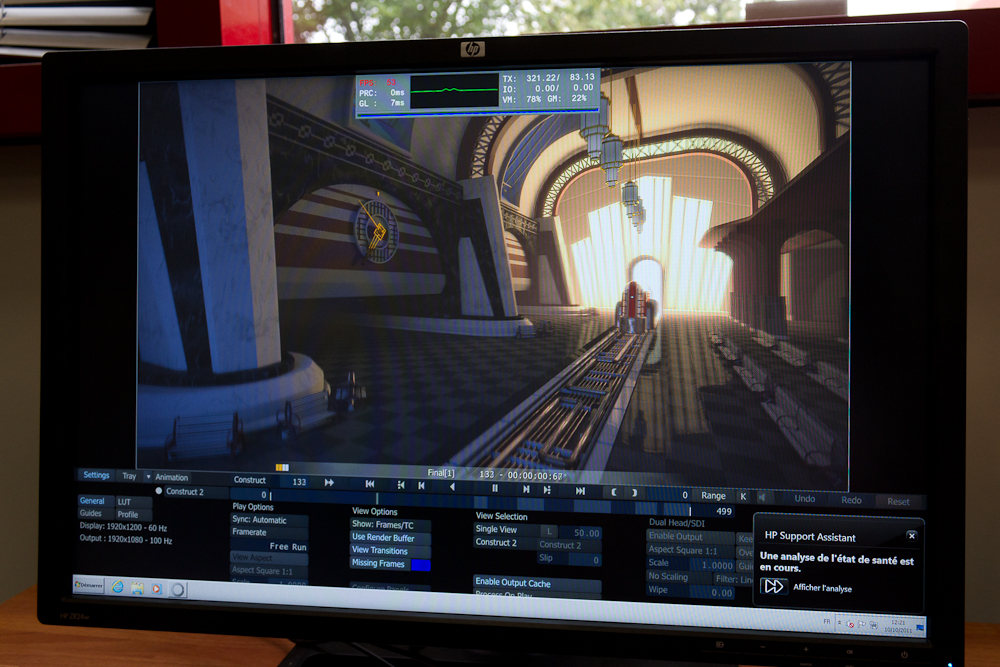

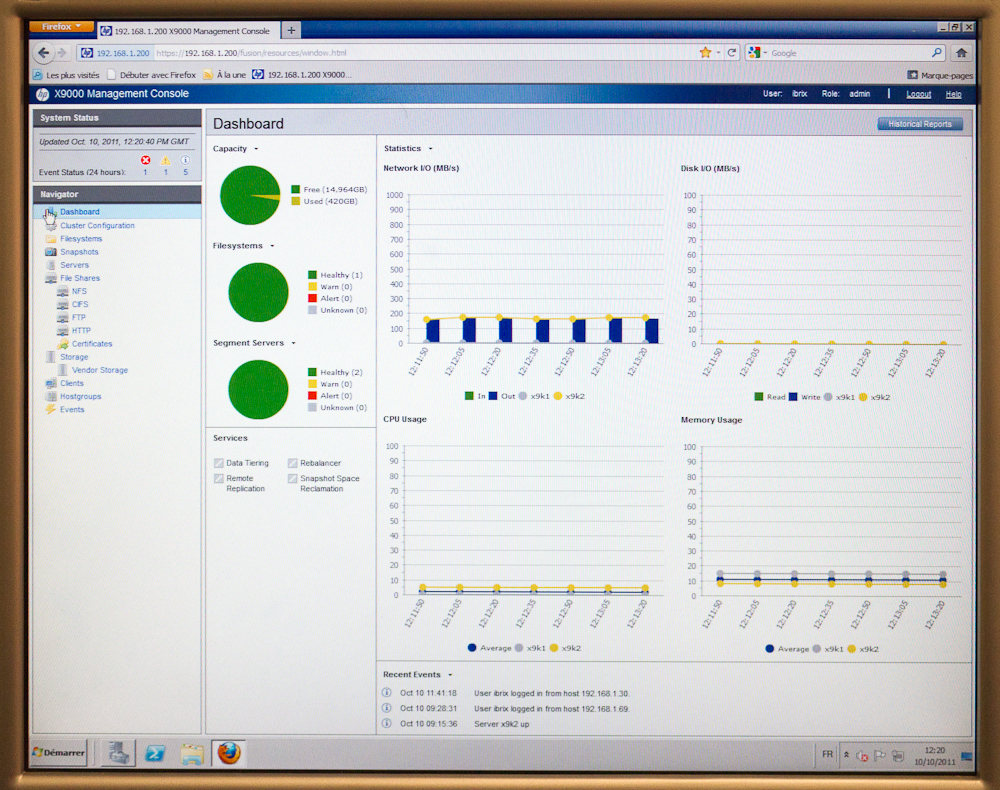

Ci-dessous, le système en pratique : lecture d’une vidéo 2k sous Scratch (50 à 80fps), et système de gestion permettant de gérer et surveiller le système :

gestion des alertes, statistiques sur les flux de données, l’usage CPU/RAM, …

|

Pour en savoir plus – Site de Progiss |

|