3DVF – Vous avez aussi travaillé sur les nombreux effets des séquences de tournage en milieu urbain, mais aussi la recréation d’une ville numérique pour l’extension de décors. Peux-tu nous en dire plus sur cette partie de la production ?

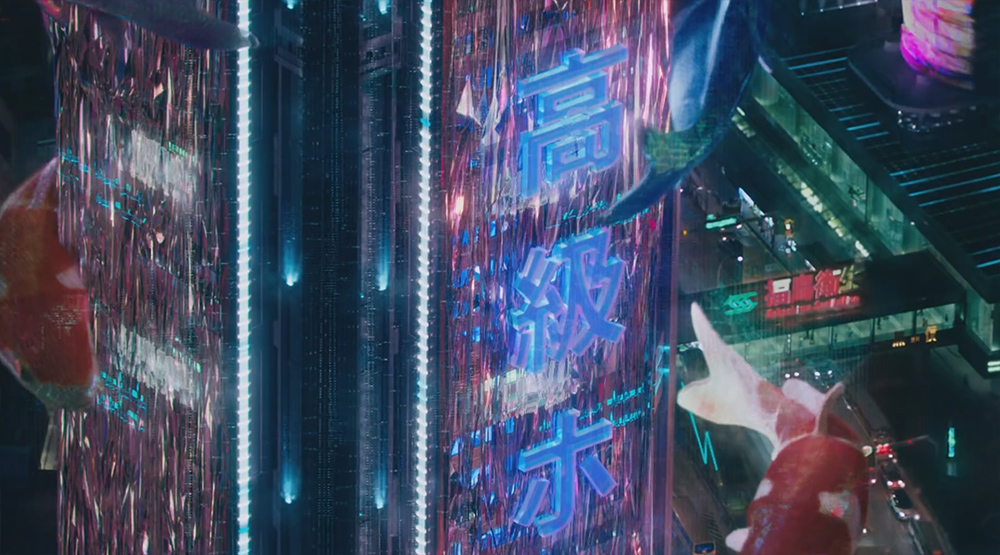

Axel Bonami : La représentation de l’environnement est une combinaison de plans d’ensemble aériens, les cinq « ghost cams » qui étaient de très longs plans de survol au-dessus de différentes parties de la ville (1 minute par plan environ), et de plans au niveau des rues. Cela a nécessité un énorme travail de création d’assets de bâtiments, de blocs d’appartements, de routes, de piliers, de rues avec les éléments de décors, ec… Tout s’est déroulé sous l’égide de notre Environment Supervisor Pier Lefebvre. Il a aussi fallu mettre en place des matte-paintings et de nombreux layout pour l’ajout des effets de solograms et d’hologrammes. Ce fut sans doute l’effet visuel le plus difficile et le plus long à mettre en œuvre sur tout le projet : en une minute de plan aérien au-dessus de la ville, on couvre plusieurs kilomètres de distance et tout doit sembler actif et vivant !

Durant l’étape de layout, nous avons mis en place les caméras, commencé à mettre en place le mélange de bâtiments anciens et plus récents. Comme ils étaient inspirés de vrais lieux à Hong-kong, nous avons pu nous lancer à partir de l’organisation d’une vraie ville. Le tournage à Hong-kong nous avait donné l’opportunité de photographier différentes zones de la ville sur la trajectoire de la Ghost Cam.

3DVF – Justement, peux-tu nous expliquer le concept de cette technique de Ghost Cam ?

Axel Bonami :Guillaume a travaillé en préproduction sur la planification sur site et sur la prévisualisation du trajet de la caméra. L’idée originale était d’avoir des plans filmés par drone, mais vu la distance à couvrir et la règlementation locale, ce n’était pas possible. On a donc envoyé notre équipe passer plusieurs nuits sur différents toits et appartements pour photographier un maximum de références possible.

Nous avons ensuite commencé à travailler à partir du vrai plan de la ville, ajouté des centaines d’assets. Une fois la caméra validée, la production VFX nous a aidés à mettre en place les principaux « sologrammes », tandis que nous travaillions à installer les centaines d’hologrammes destinés à habiller les rues, et à mettre en place le texturing, lighting et shading de notre ville.

Nous avons ensuite utilisé Alice, l’outil de simulation de foules propriétaire de MPC, pour peupler la ville de milliers de passants. Nous l’avons également adapté pour générer du trafic automobile au niveau du sol et sur les multiples niveaux d’autoroutes aériennes. Nous avons employé un processus similaire pour les autres plans d’ensemble. Les plans au niveau du sol ont utilisé une combinaison de références live-action et de bâtiments 3D, d’ajouts en matte painting, une combinaison de sologram rendus et éclairés et d’hologrammes générés au compositing à l’aide de Nuke et RenderMan dans ce dernier cas, pour générer des passes d’interaction/réflexion.

Nous avions environ 400 éléments individuels de graphic design/hologrammes/sologrammes venus de studios multiples à ingérer, combiner et utiliser en layout pour créer notre ville numérique.

Les sologrammes sont une combinaison de vraies personnes et de designs graphiques publicitaires. Les personnes ont été filmées avec le rig de Digital Air, constitué de 80 caméras vidéo HD synchronisées. Nous avons ensuite utilisé un processus de photogrammétrie sur le clip de 400 frames générés, et il y a eu environ 60-70 assets traités de cette façon.

La photogrammétrie permet de générer un modèle 3D avec des textures bakées pour chaque frame ; nous avons ensuite lancé le calcul de voxelisation à l’aide de Houdini, pour convertir ces modèles en grilles de voxels 3D qui conservent les données de textures ; nous pouvions ensuite contrôler la densité, la taille et le comportement des voxels. Nous avons mis en place des conventions de nommage internes de façon à pouvoir associer la qualité des voxels avec le lieu du sologramme concerné, certains étant plus avancés technologiquement et en meilleure résolution, d’autres moins poussés, plus basiques et avec des bugs.

Enfin, nous avons combiné certains de ces sologrammes avec des logos et publicités conçus par le studio Territory, et placé le tout dans les plans.

3DVF – Que peux-tu nous dire concernant les effets sur les personnages, et notamment les différents cyborgs ?

Axel Bonami : Nous avons plusieurs personnages hybrides dans le film. Le Major avait sa combinaise costume thermoptique, de même que deux séquences de reconstruction (corps entier dans l’une, bras dans l’autre),. Il y avait aussi les Geishas évoquées plus haut, et le personnage de Kuzé dont on peut voir à plusieurs reprises le squelette mécanique. Le travail sur les personnages suivait un processus similaire au reste : une étape de roto anim au cours de laquelle la doublure numérique est alignée sur le mouvement exact du véritable acteur, puis le département Tech Anim ajuste et améliore la précision. Cela nous donnait une version full 3D du personnage rendue avec la même lumière, qui matchait à la perfection à l’acteur réel. Nos versions 3D ont des muscles qui bougent, du jiggle/flex comme de vrais muscles, des simulations de cloth pour les mouvements de tissu, etc. Nous pouvions donc reproduire la réalité et fusionner quand il le faut les éléments réels avec notre travail en 3D.

Pour Kuzé, nous avons tracké les subtilités des mouvements du visage du vrai acteur pour les recréer en 3D . Au final, son visage est donc un mix de 3D et de live action. Dans certains plans son bras gauche est réel, dans d’autres il est en 3D. Je ne vous dirai pas de quels plans il s’agit : si vous n’arrivez pas à faire la différence par vous-même, c’est que nous avons bien bossé !

3DVF – Pour plaire aux fans et coller à l’original, il y aussi la fameuse combinaison Thermoptic du Major et son effet d’invisibilité . Comment avez-vous abordé et réalisé cet effet ?

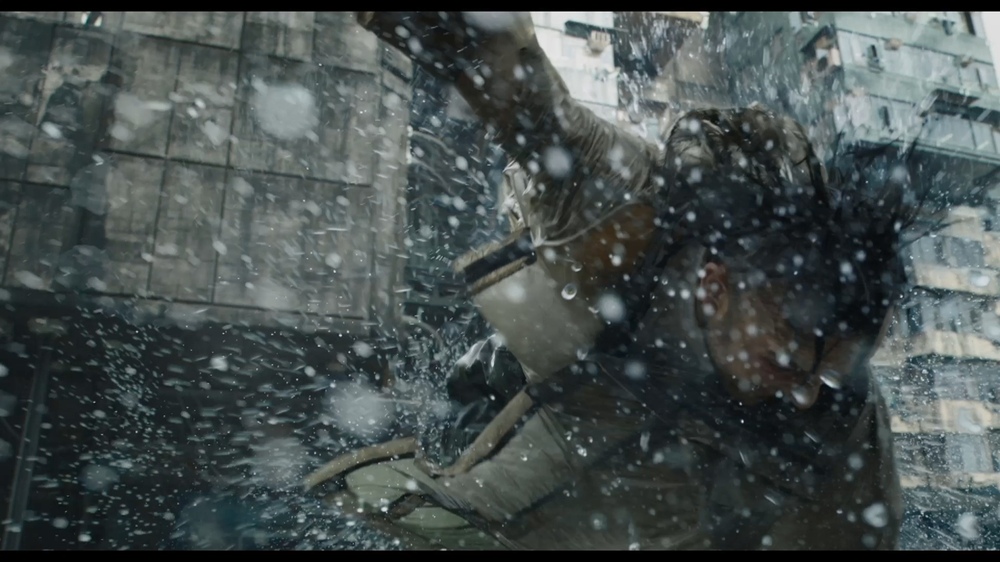

Axel Bonami : L’effet d’invisibilité était un autre gros défi. Même si des effets de cape d’invisibilité ont déjà été réalisés au cinéma, nous devions créer une nouvelle façon de visualiser ce concept. Nous avons en fait utilisé un langage graphique similaire pour le système d’invisibilité et les Sologrammes. La voxelisation nous a permis de générer une sorte de grille de voxels 3D composée de petits cubes/pixels, qui pouvaient être activés par proximité. Nous pouvions ainsi contrôler la taille, la durée de vie et nous pouvions générer des artefacts numériques autour du sujet. C’est comme si le Major générait autour d’elle un champ de pixels 3D qui peuvent ensuite avoir différentes réponses optiques : réflexion, réfraction, auto-occlusion, opacité…

Nous avons généré ensuite des maps pour les différents panneaux de la combinaison afin de pouvoir jouer sur différents niveaux d’artefacts. L’invisibilité devient ainsi la somme d’artefacts de réflexion, réfraction, opacité, transparence totale et compression colorimétrique, avec des maps de vélocité pour combiner le tout.

Pour les interactions, différentes méthodes ont été utilisées. Il y a des plans dans lesquels le Major est réellement dans le plan et nous l’avons rendue invisible, d’autres où elle n’y est pas et avons ajouté sa version invisible.

Pour la séquence du « Skinny Man » où le major se bat avec un homme dans l’eau et qu’elle le projette en l’air, notre équipe de RotoPrep l’a supprimée de l’image à l’aide de plans vierges, et on ensuite projetée la version numérique en faisant un travail de peinture numérique image par image. Cela nous a permis de conserver une partie des interactions avec l’eau, et nous avons pu faire de la rotoscopie sur la performance, puis faire un rendu des éléments numériques dont nous avions besoin pour obtenir l’effet d’invisibilité. Nous avons aussi utilisé des simulations d’eau classiques pour raccorder le tout.