Daniel Cudeiro*, Timo Bolkart*, Cassidy Laidlaw, Anurag Ranjan et Michael J. Black (*ceux deux auteurs ont contribué de manière égale au projet) dévoilent VOCA, ou Voice Operated Character Animation. Ce projet de recherche a un objectif simple en apparence : animer un visage à partir de l’enregistrement audio du texte prononcé.

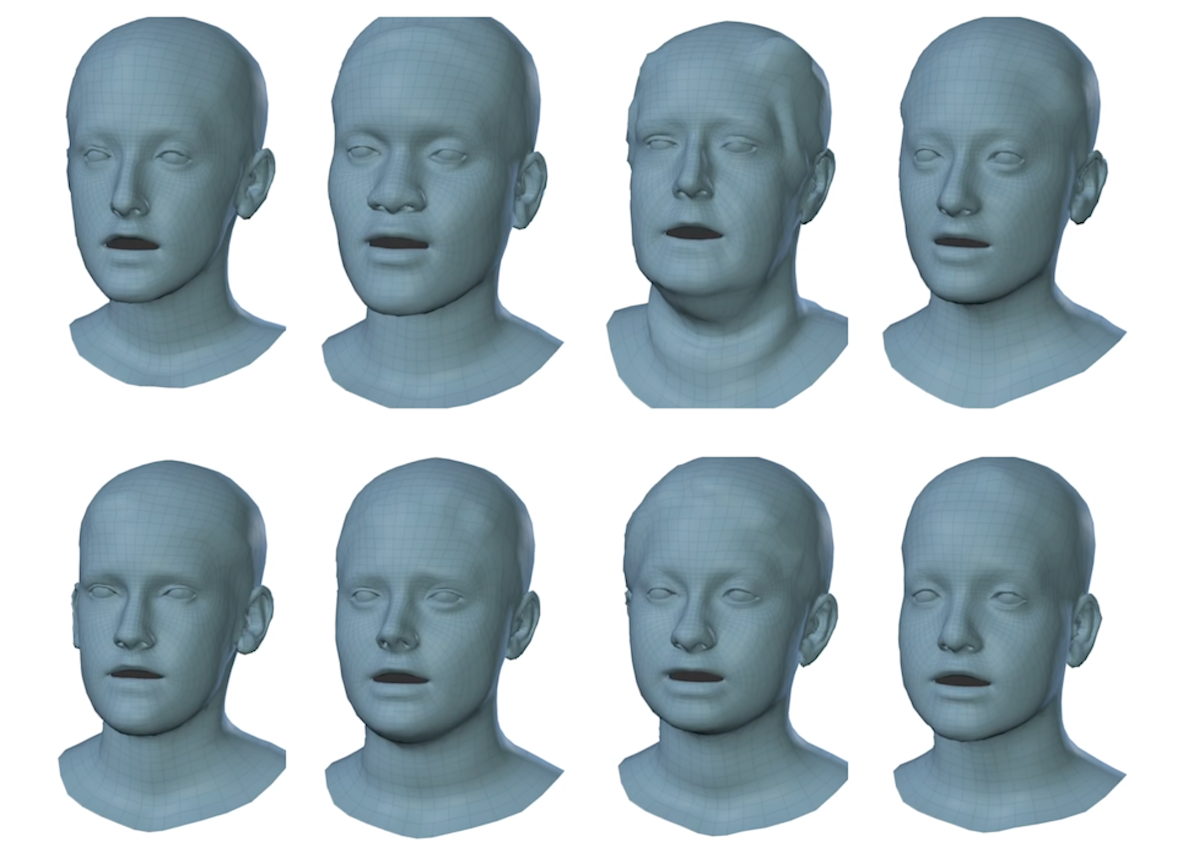

Si ce concept est déjà proposé avec des résultats variables par certains outils, VOCA cherche à proposer plus de réalisme mais aussi à généraliser l’approche. Les chercheurs ont enregistré 12 sujets humains et 480 séquences de 3 à 4 secondes. Le résultat : environ 29 minutes de scans 4D (séquences de scans 3D capturés successivement) à 60 images par seconde. A partir de l’audio synchronisé et des scans, ils ont pu entraîner un réseau de neurones. Le résultat est le système VOCA.

L’objectif des chercheurs est de généraliser le système à des cas très variés : accents, vitesse d’élocution, bruit, variation de forme du visage… De quoi rendre VOCA utile pour des domaines tels que le jeu vidéo, les avatars en réalité virtuelle et plus globalement pour n’importe quel cas où la personne qui parle, le type d’élocution ou même la langue ne sont pas connus à l’avance.

Notez enfin que la page du projet permet d’accéder au modèle et à l’ensemble des données utilisées, pour les personnes qui voudraient faire leur propres recherches sur le sujet.